L’IA est‑elle neutre ou reproduit‑elle nos biais ?

La croyance répandue veut que l’IA soit totalement objective et impartiale. En réalité, elle peut reproduire et amplifier nos biais sociaux. Cet article explore les mécanismes, des cas concrets très chiffrés, et les solutions possibles.

Pourquoi croit‑on que l’IA est neutre ?

On envisage l’IA comme une technologie « logique », sans émotions. Elle prend des décisions sur la base d’algorithmes et ne devrait pas refléter nos opinions. Pourtant, rien n’indique qu’elle soit exempte de biais, surtout si les données d’apprentissage contiennent des stéréotypes.

Comment l’IA apprend les biais

Un modèle d’IA se nourrit de données massives (textes, images, historiques). Si ces données comportent des distorsions — par exemple peu de femmes ingénieures, ou majoritairement des visages clairs — l’IA réplique ces déséquilibres.

Cas réels de biais IA (avec chiffres et sources)

Plusieurs scandales ont montré que l’IA reproduit nos biais.

Chez Amazon, un outil de recrutement utilisé entre 2014 et 2018 a été abandonné après qu’il a été découvert qu’il pénalisait les CV contenant le mot “women’s” et déclassait les diplômées d’écoles féminines (Reuters).

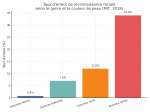

Une étude du MIT (2018) a révélé que certains systèmes de reconnaissance faciale affichaient jusqu’à 34 % d’erreurs pour les femmes à peau noire, contre moins de 1 % pour les hommes blancs (MIT Media Lab).

L’algorithme COMPAS, utilisé dans la justice américaine, a quant à lui attribué deux fois plus de faux positifs aux Afro‑Américains qu’aux Blancs en matière de risque de récidive (ProPublica).

En 2017, des chercheurs de Stanford ont montré que Google Translate traduisait environ 70 % des phrases neutres en turc en attribuant un genre stéréotypé : doctor → il, nurse → elle.

Enfin, un rapport de l’UNESCO (2021) souligne que 80 % des assistants vocaux utilisent une voix féminine par défaut, renforçant certains stéréotypes de genre (UNESCO).

Pourquoi ces biais posent-ils problème ?

L’illusion d’objectivité masque des discriminations. Dans le recrutement, le crédit ou la justice, une IA biaisée peut renforcer les inégalités existantes, souvent sans que l’utilisateur s’en rende compte.

Comment réduire les biais ?

Plusieurs pistes :

- Construire des datasets diversifiés, représentatifs de toutes les populations.

- Utiliser des algorithmes de débiaisage (adversarial learning, re‑weighting).

- Faire appel à des audits éthiques externes.

- Mettre en place des régulations comme le AI Act en Europe, qui impose transparence et évaluation des risques.

Conclusion

L’IA n’est pas neutre par défaut, mais elle peut évoluer vers plus d’équité si plusieurs conditions sont remplies : des données équilibrées, des équipes plurielles, des audits et des cadres réglementaires. Il faut conjuguer esprit critique et innovation.

Sources

L’IA peut-elle être totalement neutre ?

En théorie, mais en pratique c’est très difficile. Même un modèle bien entraîné peut reproduire des biais invisibles si les données sont déséquilibrées ou que les tests ne couvrent pas tous les profils.

Quel est le biais le plus documenté en reconnaissance faciale ?

Le biais de peau et de genre : les femmes à peau foncée sont identifiées incorrectement jusqu’à 34 % du temps, contre moins de 1 % pour les hommes à peau claire (MIT Media Lab).

Que faire si une IA prend une décision injuste ?

Contester la décision, demander un audit, et signaler aux autorités compétentes (CNIL, justice). Le AI Act impose maintenant une traçabilité des décisions automatisées.

Qui est responsable des biais dans une IA ?

Principalement les équipes qui conçoivent, entraînent et déploient les modèles, mais aussi les décideurs qui choisissent les données, les tests et la supervision.