Deepfakes : la fin de la vérité est-elle inévitable ?

Les deepfakes suscitent de vives inquiétudes. Ces vidéos truquées, générées par l'intelligence artificielle, semblent capables de manipuler l'opinion publique et de rendre la vérité insaisissable. Mais la situation est-elle aussi catastrophique qu'on le pense ?

Qu'est-ce qu'un deepfake ?

Un deepfake est une vidéo falsifiée grâce à l'IA, capable d'imiter la voix et le visage de n'importe qui. Cette technologie repose sur des réseaux neuronaux, notamment les GAN (Generative Adversarial Networks). Elle est déjà utilisée pour créer des vidéos humoristiques, des effets spéciaux au cinéma ou des contenus malveillants comme de la désinformation politique ou des escroqueries.

Pourquoi les deepfakes inquiètent-ils autant ?

Les deepfakes pourraient servir à diffuser de fausses informations de manière crédible. Des vidéos truquées d'hommes politiques, de PDG ou de journalistes peuvent influencer l'opinion publique, provoquer des crises diplomatiques ou nuire à des réputations. Cette menace est prise au sérieux par les institutions comme l'ONU ou l'Union européenne, qui travaillent déjà sur des lois pour encadrer ces usages.

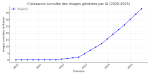

Une explosion d'images générées par IA

Dès 2022, l’essor de générateurs comme DALL‑E 2 et Stable Diffusion conduit à la création de plus de 15 milliards d’images en moins d’un an. En 2023, le rythme moyen atteint 34 millions d’images générées chaque jour, illustrant l'adoption massive de ces outils. En 2024, Stable Diffusion représente à lui seul 80 % du total des images créées, soit environ 12,5 milliards d’images. En avril 2025, ces standards se maintiennent avec environ 34 millions d’images quotidiennes générées via plus d'un millier d’outils d’IA disponibles sur le marché. Ces chiffres montrent à quel point la production de contenu artificiel explose, ce qui accroît mécaniquement les risques de désinformation via les deepfakes.

Les outils de détection se perfectionnent

Des entreprises comme Microsoft, Google ou Adobe développent déjà des systèmes pour identifier les contenus falsifiés. Des projets comme Content Credentials visent à intégrer des signatures numériques aux images et vidéos, permettant de vérifier leur authenticité. Parallèlement, des startups conçoivent des algorithmes capables de repérer les anomalies générées par l'IA.

Un débat éthique sur la liberté d'expression

Limiter les deepfakes pose une question complexe : où placer la frontière entre régulation et liberté d'expression ? Les deepfakes peuvent être utilisés de manière créative dans l'art ou l'humour. Une interdiction totale risquerait de censurer des usages légitimes. C'est pourquoi les législateurs cherchent à distinguer les usages nuisibles (désinformation, fraude, harcèlement) des usages acceptables.

Sources

Les deepfakes sont-ils déjà utilisés en politique ?

Oui. Des vidéos truquées de candidats ont déjà circulé dans plusieurs pays. Cependant, les médias et les plateformes sociales renforcent leurs dispositifs de vérification pour limiter leur impact.

Comment reconnaître un deepfake ?

Des outils comme Hive, Deepware ou Sensity AI analysent les vidéos et repèrent les incohérences. À l'avenir, des métadonnées inviolables permettront de certifier les contenus authentiques.

Les deepfakes doivent-ils être interdits ?

Pas nécessairement. Ils doivent être encadrés. L'objectif est de sanctionner les usages malveillants sans freiner la création artistique, la satire ou l'innovation technologique.